不要陷入AI盲从

AI First虽然很好,但是,没有专业判断力,就很容易变成AI盲从 我曾经以为,在AI时代,AI First(AI优先)原则,可以适用于大多数人,且大多数人也将因为这个习惯或思维而受益 但现在发现,这个观点是有问题的

AI First虽然很好,但是,没有专业判断力,就很容易变成AI盲从

我曾经以为,在AI时代,AI First(AI优先)原则,可以适用于大多数人,且大多数人也将因为这个习惯或思维而受益

但现在发现,这个观点是有问题的

实际上,是需要分情形的

首先,大部分人,可能并不能真正理解AI的能力边界在哪里

尤其是对于很多特定的专业工作场景,很容易搞混,哪些是AI知道的,哪些是AI不知道的

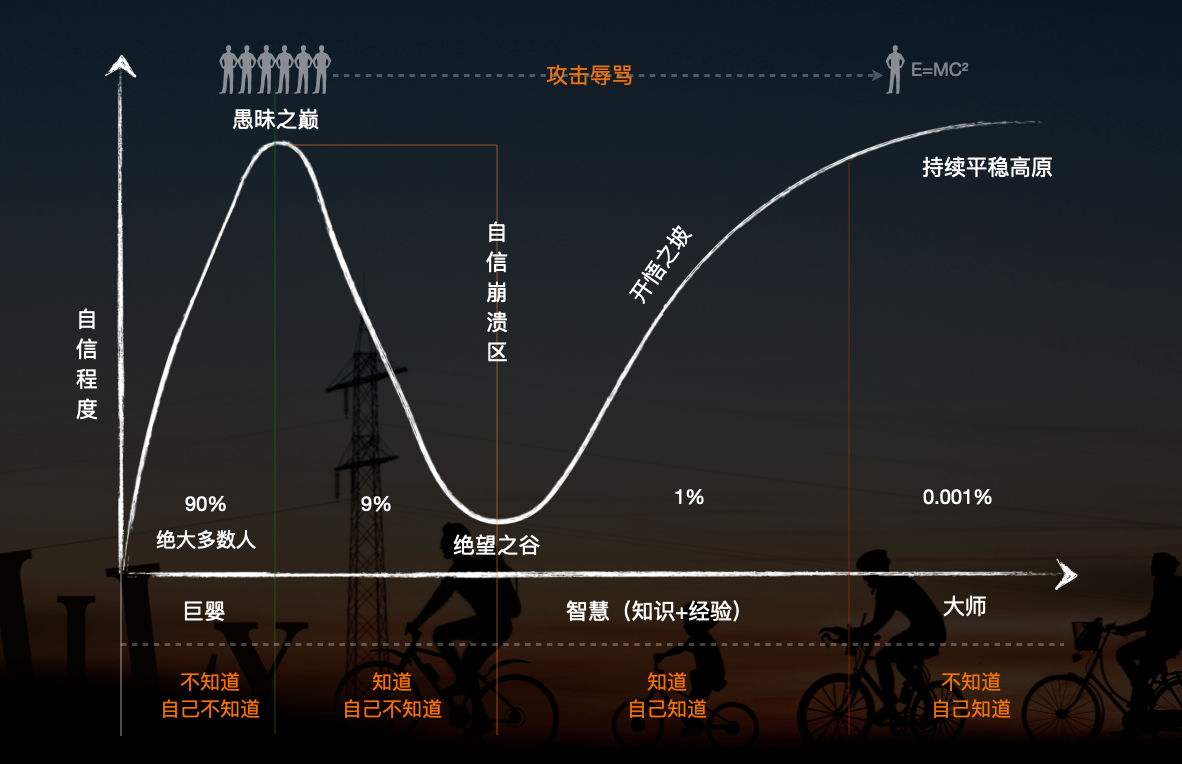

其次,是大部分人,对自己的能力边界,很难有正确的认知,在很多情况下,不知道自己不知道

所以即便产出的东西是垃圾,也不自知

参考下图:

我觉得更可怕的,是因为慢慢习惯了AI的协助之后,对AI产生的结果,会由开始的谨慎处理,再慢慢到后面的盲从,这种对AI的盲从背后,是因为慢慢丧失了专业判断力,甚至是对常识的判断能力,这种变化是很可怕的

其实不仅仅是在专业领域有这样的情况,在很多常识层面,面对AI对常识性问题的幻觉,普通人也难以察觉

看了一个新闻

两名游客,计划从海边步行前往一个小岛

出发前,他们问了ChatGPT一个问题:今天什么时候退潮?

ChatGPT的回答是:早上9点半

于是他们就出发了,但实际上ChatGPT这个回答是错误的,在这个过程中,他们并没有去进一步求证,也没有问酒店的工作人员或者酒店的安全手册

后来,当两个人步行到岛上,准备返回时,潮水开始疯狂上涨了,堤道已被淹没,且快速形成了很深的潮汐落差

事后,一名游客在采访中说:“我犯了个错误,用ChatGPT查低潮时间。它告诉我上午9点半。所以我们去了那边,结果回来的时候情况完全不一样了。这对我来说,是一次深刻的教训。”

前几天,我问ChatGPT静息心率与睡眠平均心率的关系,它很自信的输出了一个不太符合常识的回答,于是我多处查找资料验证,发现ChatGPT的回答错得离谱

这种错误,无论是对一些生活中的问题,还是工作中的问题,AI的输出总是会经常性的出现各种错误

这个时候,就非常考验我们的批判性思维与专业判断力,尤其是对于一些重要的问题,如果缺乏这两种能力,就会很容易变成“AI盲从”,这是一件很可怕的事情

而具备批判性思维与专业判断力,比想象的,要难得多

所以,我现在开始更多的建议,对于少部分关键工作,不要轻易的依赖AI,对AI保持批判,这个时候,应该优先通过权威可信的资料或专家及实践,让自己具备真正的专家级水平,这个时候,再去借助AI提效,才有可能驾驭好它

否则,我目前看到的案例,大都惨不忍睹,看似“提效”,其实都是在输出“垃圾”